Les grands modèles de langage (LLM) devenant rapidement un élément essentiel du développement des logiciels modernes, une étude récente indique que plus de la moitié des développeurs seniors (53 %) pensent que ces outils peuvent déjà coder plus efficacement que la plupart des humains. Ces modèles sont utilisés quotidiennement pour déboguer les erreurs délicates, générer des fonctions plus propres et réviser le code, ce qui permet aux développeurs d'économiser des heures de travail. Mais avec la sortie rapide de nouveaux LLM, il n'est pas toujours facile de savoir lesquels valent la peine d'être adoptés. C'est pourquoi nous avons créé une liste des 6 meilleurs LLM pour le codage qui peuvent vous aider à coder plus intelligemment, à gagner du temps et à augmenter votre productivité.

6 meilleurs LLM pour le codage à envisager en 2026

Avant de nous plonger plus avant dans notre sélection, voici ce qui vous attend :

|

Modèle |

Meilleur pour |

Précision |

Raisonnement |

Fenêtre contextuelle |

Coût |

Soutien de l'écosystème |

Disponibilité d'une source ouverte |

|

GPT-5 (OpenAI) |

Meilleur résultat global |

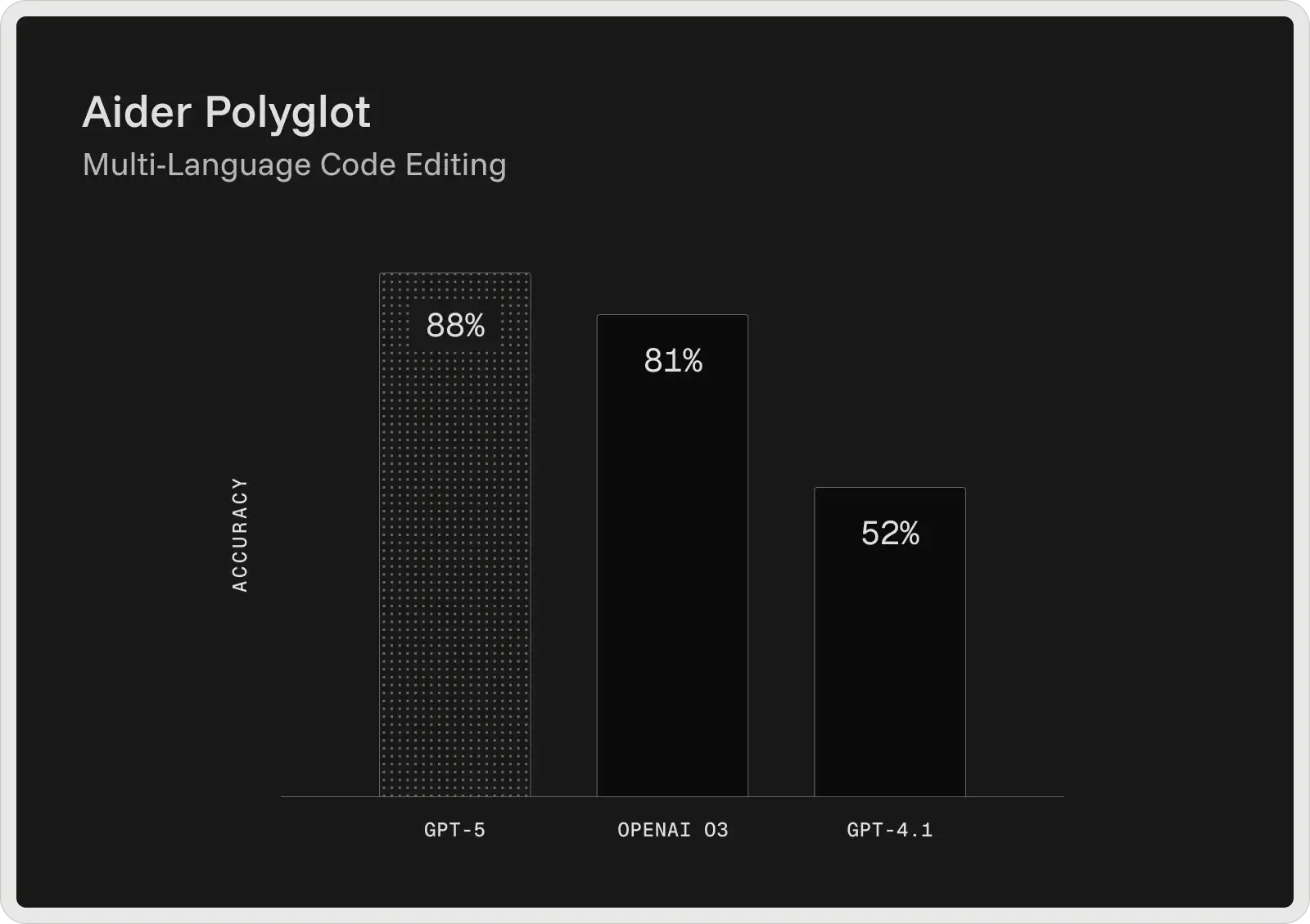

74,9 % (SWE-bench) / 88 % (Aider Polyglot) |

Raisonnement en plusieurs étapes, flux de travail collaboratif |

400K tokens (272K en entrée + 128K en sortie) |

Gratuit + plans payants à partir de 20$/mois |

Très solide (plugins, outils, intégration des développeurs) |

Fermé |

|

Claude 4 Sonnet (Anthropic) |

Débogage complexe |

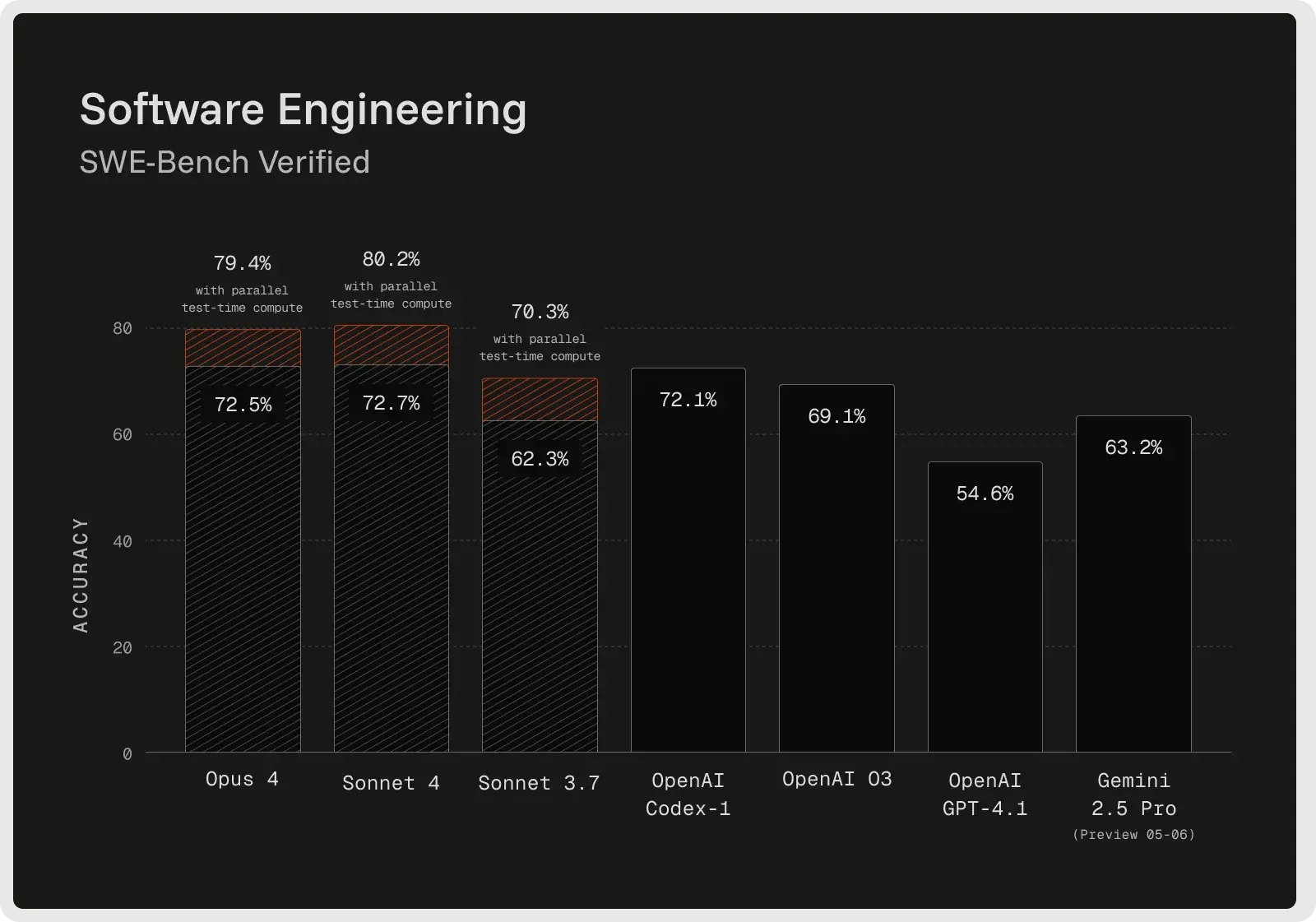

72.7% (SWE-bench vérifié) |

Débogage avancé, planification, suivi des instructions |

128K jetons |

Plans gratuits et payants à partir de 17 $/mois |

Ecosystème en pleine croissance avec des intégrations d'outils |

Fermé |

|

Gemini 2.5 Pro (Google) |

Grandes bases de code et pile complète |

SWE-bench vérifié : ~63,8 % (codage agentique) ; LiveCodeBench : ~70,4 % ; Aider Polyglot : ~74,0 %. |

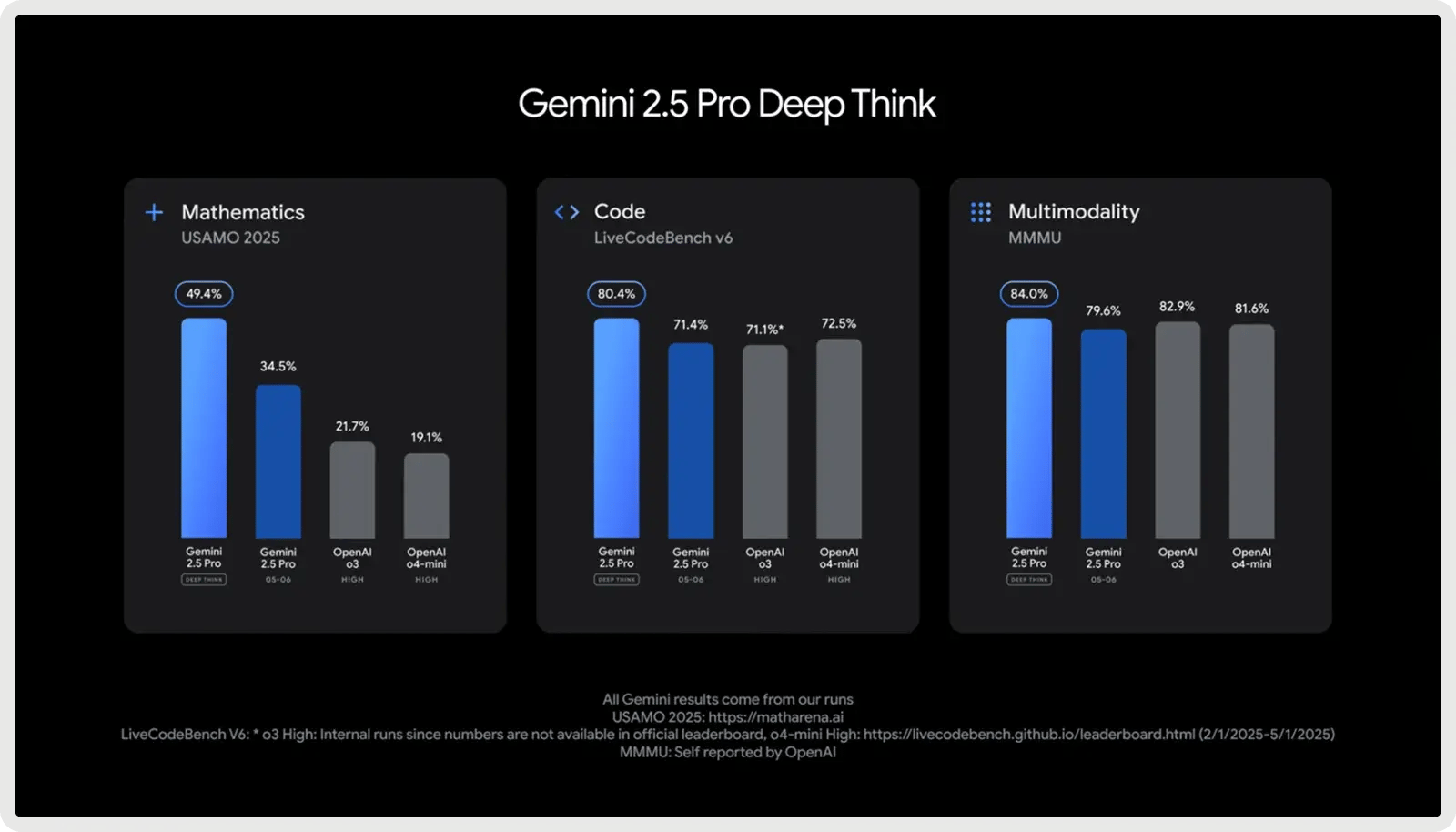

Raisonnement contrôlé ("Deep Think"), flux de travail en plusieurs étapes |

1 000 000 de jetons |

1,25 $ par million d'entrées + 10 $ par million de sorties |

Fort (outil Google et intégration API) |

Fermé |

|

DeepSeek V3.1 / R1 |

Meilleur rapport qualité-prix (Open-Source) |

Correspond aux anciens modèles de l'OpenAI, se rapproche de Gemini en matière de raisonnement |

Logique et autoréflexion adaptées à la RL |

128K jetons |

Entrée : 0,07-0,56 $/M, Sortie : $1.68-2.19/M |

Moyen (adoption du code source ouvert, flexibilité pour les développeurs) |

Ouvert (licence MIT) |

|

Llama 4 (Meta : Scout / Maverick) |

Open-Source (contexte large) |

Excellentes performances en matière de codage et de raisonnement dans les modèles de référence ouverts |

Bon raisonnement étape par étape (moins avancé que GPT-5/Claude) |

Jusqu'à 10 millions de jetons (Scout) |

0,15-0,50 $/M en entrée, 0,50-0,85 $/M en sortie |

Écosystème open-source en pleine expansion, outils pour les développeurs |

Poids libres |

|

Claude Sonnet 4.5 (Anthropic) |

Débogage collaboratif et tâches à contexte long |

Estimé à ~75-77% (classe SWE-bench) |

Raisonnement agentique hybride, utilisation autonome d'outils et planification |

200K jetons |

3 $/M en entrée + 15 $/M en sortie |

Extension de l'écosystème anthropique avec des chaînes d'outils agentiques |

Fermé |

1. Meilleure solution globale : GPT-5 d'OpenAI

Le GPT-5 d'OpenAI est actuellement le modèle de codage le plus puissant de sa gamme, offrant les meilleurs résultats dans les benchmarks de développeurs les plus utilisés. Sur le banc d'essai SWE Verified, il atteint 74,9 % de précision et sur Aider Polyglot, il obtient 88 %, réduisant ainsi les taux d'erreur par rapport aux modèles précédents, tels que GPT-4.1 et o3. Conçu comme un assistant de codage collaboratif, GPT-5 peut générer et modifier du code, corriger des bogues et répondre à des questions complexes sur de grandes bases de code avec cohérence.

Il fournit des explications avant et entre les étapes, suit des instructions détaillées de manière fiable et peut exécuter des tâches de codage en plusieurs étapes sans perdre de vue le contexte. Lors des tests internes, il a également été privilégié pour le développement de l'interface utilisateur, les développeurs préférant ses résultats à ceux d'o3 dans environ 70 % des cas.

Principales capacités :

- Fenêtre contextuelle de 400K tokens - Gère 272K tokens d'entrée + 128K tokens de sortie, permettant l'analyse à l'échelle du référentiel, l'ingestion de documentation, et le raisonnement multi-fichier.

- Détection avancée des bogues et débogage - Identifie les problèmes profondément cachés dans les grandes bases de code et fournit des correctifs validés avec un raisonnement clair.

- Intégration et enchaînement d'outils - Appelle des outils externes de manière fiable, en prenant en charge des flux de travail séquentiels et parallèles avec moins d'échecs.

- Fidélité des instructions - Respecter scrupuleusement les instructions détaillées du développeur, même pour les tâches en plusieurs étapes ou très contraignantes.

- Flux de travail collaboratifs - Partage des plans, des étapes intermédiaires et des mises à jour de l'état d'avancement au cours de longues sessions de codage.

- Raisonnement à long terme - Maintient la cohérence des projets de grande envergure, en préservant les dépendances et la logique sur des centaines de milliers de jetons.

- Récupération fiable de contenu - Excellentes performances lors des tests de recherche en contexte long (par exemple, OpenAI-MRCR, BrowseComp), ce qui lui permet de localiser et d'utiliser des informations enfouies dans de très grandes entrées.

Avantages et inconvénients :

🟢 Pour :

- Traite plus efficacement les tâches de codage plus longues et les grandes bases de code.

- Suit des instructions détaillées avec une plus grande précision.

- Capte des bogues subtils que d'autres modèles manquent souvent.

- Produit des réponses plus propres, moins "hallucinées" dans certains cas.

- Difficulté à mettre en œuvre des plans complexes à plusieurs étapes.

- Il arrive que le code soit halluciné ou incomplet.

- La vitesse de réponse est plus lente et la qualité des résultats est incohérente.

- Le code généré peut être trop confiant mais fragile.

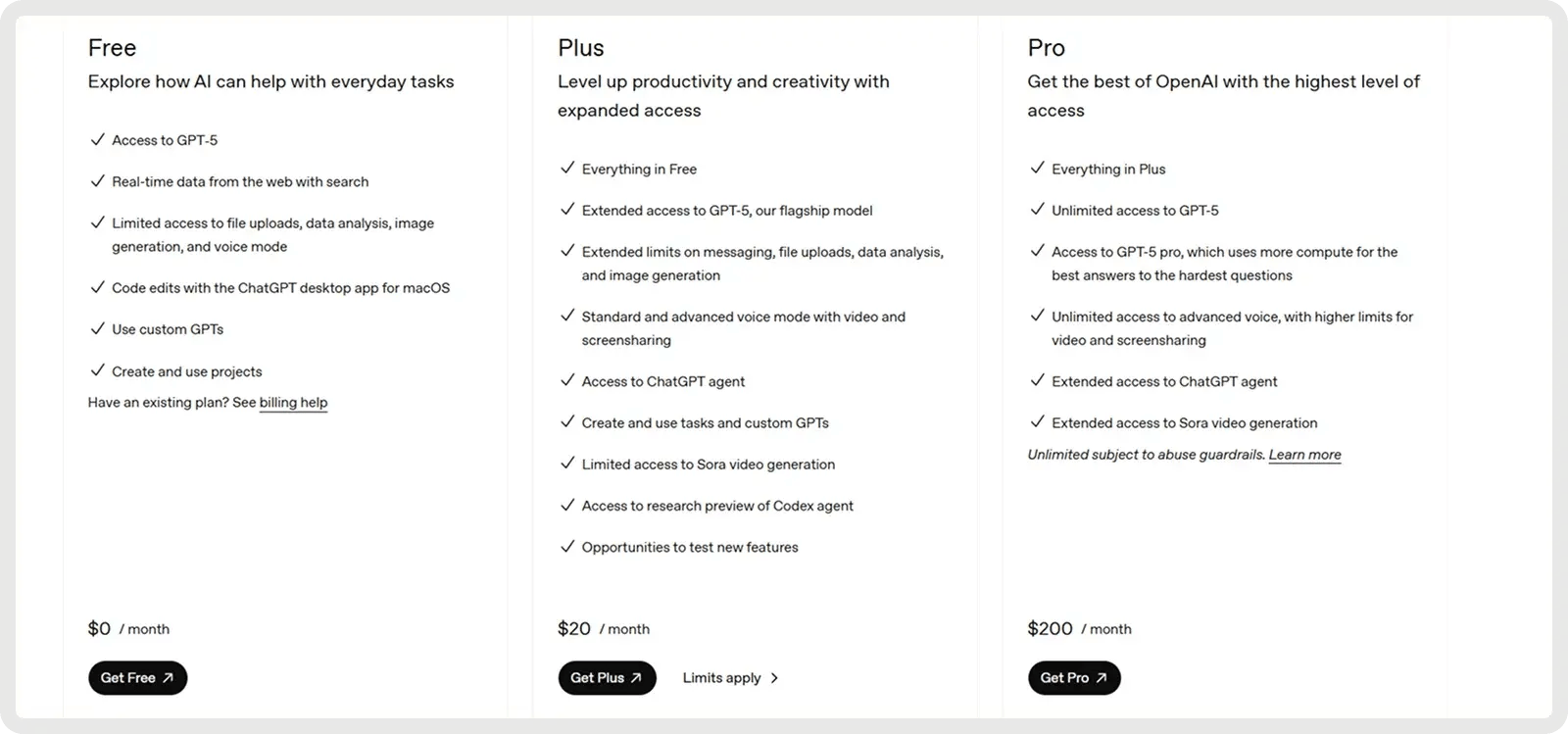

Tarification

OpenAI's GPT-5 offre un plan gratuit et 2 plans payants à partir de 20 $ par mois.

2. Meilleur pour le débogage complexe : Anthropic Claude 4 (Sonnet 4)

Claude Sonnet 4 est construit pour un raisonnement avancé et est très performant dans le débogage complexe et la revue de code. Le modèle décrit souvent un plan avant de faire des modifications, ce qui améliore la clarté et aide à détecter les problèmes plus tôt dans le processus. Sur le benchmark SWE-Bench Verified, il a atteint une précision de 72,7 % sur des corrections de bogues réelles, établissant un nouveau record et surpassant la plupart des concurrents. Son mode de réflexion étendu permet d'utiliser jusqu'à 128 000 jetons, ce qui lui permet de traiter de grandes bases de code et des documents d'appui tout en réduisant les hallucinations grâce à des questions de clarification. Les développeurs signalent moins d'erreurs, un traitement plus fiable des demandes ambiguës et des corrections incrémentielles plus sûres que les approches ponctuelles.

Principales capacités :

- Développement sur l'ensemble du cycle de vie - Prise en charge de l'ensemble du processus, de la planification et de la conception au remaniement, au débogage et à la maintenance à long terme.

- Suivi des instructions et utilisation des outils - Sélectionne et intègre des outils externes (par exemple, API de fichiers, exécution de code) dans les flux de travail en fonction des besoins.

- Détection des erreurs et débogage - Identifie, explique et résout les bogues en justifiant clairement les modifications apportées au code.

- Refonte et transformation du code - Réaliser des restructurations à grande échelle sur des fichiers ou des bases de code entières.

- Génération de précision et planification - Produire un code propre et structuré, aligné sur la conception et les objectifs du projet.

- Raisonnement sur des contex tes étendus - Maintien de la cohérence sur des contextes étendus pour des bases de code volumineuses ou des documents longs.

- Respect fiable de la logique - Évite les raccourcis fragiles et suit la logique prévue avec une plus grande cohérence.

Avantages et inconvénients :

🟢 Pour :

- Fort pour générer et compléter des tâches de codage plus importantes.

- Suit les instructions de manière plus fiable que les versions précédentes.

- Coût et performance équilibrés par rapport à Opus.

- Fournit des codes clairs et bien structurés.

- Peut mal comprendre des demandes simples ou donner trop d'explications.

- Plus faible pour l'OCR et les tâches de codage lourdes.

- Difficulté à résoudre des problèmes très complexes en plusieurs étapes.

- La cohérence des résultats peut varier d'un domaine de codage à l'autre.

Tarification

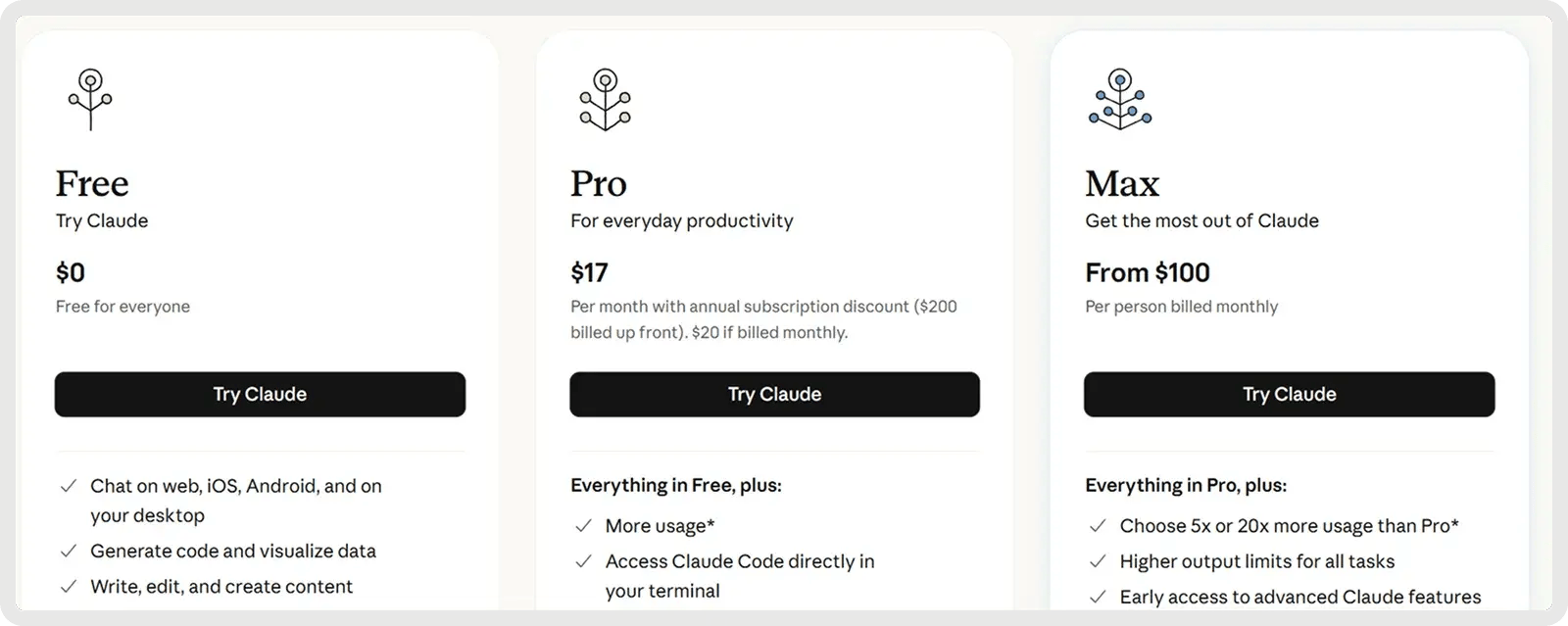

Claude propose un plan gratuit et 2 plans payants à partir de 17$ par mois.

3. Meilleur pour les grandes bases de code et les piles complètes : Google Gemini 2.5 Pro

Google Gemini 2.5 Pro est conçu pour les projets de codage à grande échelle, avec une fenêtre contextuelle de 1 000 000 de clés qui lui permet de gérer des référentiels entiers, des suites de tests et des scripts de migration en un seul passage. Optimisé pour le développement de logiciels, il excelle dans la génération, le débogage et le remaniement de code à travers de multiples fichiers et frameworks. Il prend en charge les flux de codage complexes, de la gestion des dépendances multi-fichiers au raisonnement sur les requêtes de base de données et les intégrations d'API. Avec des réponses rapides et une prise en compte de l'ensemble de la chaîne, il aide les développeurs à écrire, analyser et intégrer du code dans les couches frontales, dorsales et de données de manière transparente.

Principales fonctionnalités :

- Génération de code - Création de nouvelles fonctions, de modules ou d'applications complètes à partir d'invites ou de spécifications.

- Édition de code - Application de correctifs, d'améliorations ou de remaniements ciblés directement dans les bases de code existantes.

- Raisonnement en plusieurs étapes - Décompose les tâches de programmation complexes en étapes logiques et les exécute de manière fiable.

- Développement Frontend/UI - Construire des composants web interactifs, des mises en page et des styles à partir d'un langage naturel ou de conceptions.

- Gestion de bases de code volumineuses - Comprend et navigue dans des référentiels entiers avec des dépendances multi-fichiers.

- Intégration MCP - Prise en charge du protocole Model Context pour une utilisation transparente des outils de codage open-source.

- Raisonnement contrôlable - Ajuste la profondeur de résolution des problèmes ("mode de réflexion") pour équilibrer la précision, la vitesse et le coût.

Avantages et inconvénients :

🟢 Pour :

- Excelle à générer des solutions complètes à partir de zéro.

- Gère de grandes bases de code avec un contexte de 1M-token.

- Excellentes performances dans les tâches de codage.

- Deep Think stimule le raisonnement pour les problèmes complexes.

🔴 Cons:

- Plus faible pour le débogage et les corrections de code.

- Parfois halluciné ou changeant le code sans qu'on le lui demande.

- Sorties verbeuses et incohérences de format.

- Fiabilité mitigée par rapport aux versions précédentes.

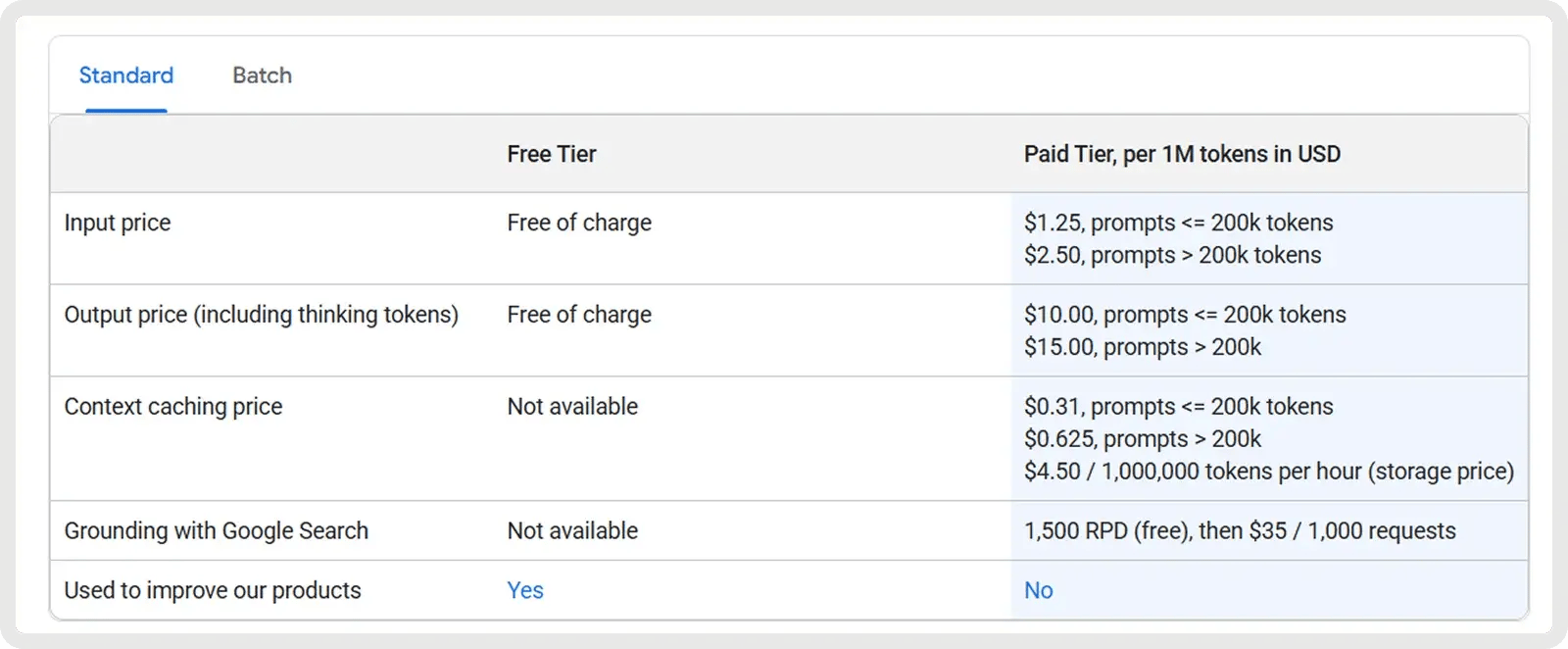

Prix

Google Gemini 2.5 Pro propose un plan gratuit et un plan payant à partir de 1,25 $ par million de jetons d'entrée et de 10 $ par million de jetons de sortie. Des tarifs supplémentaires s'appliquent pour les invites dépassant 200k jetons, ainsi que des frais optionnels de mise en cache et de mise à la terre.

4. Meilleur rapport qualité-prix (Open-Source) : DeepSeek V3.1/R1

Les modèles V3.1 et R1 de DeepSeek offrent un excellent rapport qualité-prix pour les développeurs qui recherchent à la fois un prix abordable et la flexibilité d'un logiciel libre. Ces modèles de mélange d'experts, sous licence MIT, sont spécifiquement optimisés pour les tâches mathématiques et de codage. Le modèle R1 est finement ajusté avec l'apprentissage par renforcement pour le raisonnement avancé et la logique, démontrant des performances qui égalent ou dépassent celles des anciens modèles OpenAI et s'approchent de Gemini 2.5 Pro sur des benchmarks de raisonnement complexes.

Capacités clés :

- Efficacité du mélange d'experts - L'activation d'un sous-ensemble d'experts par requête permet d'obtenir une capacité élevée tout en maintenant des coûts d'inférence inférieurs à ceux des modèles denses.

- Apprentissage par renforcement pour le raisonnement (R1) - Affiné avec l'apprentissage parrenforcement pour améliorer le raisonnement par chaîne de pensée, l'inférence logique et la précision étape par étape.

- Performances mathématiques et logiques avancées - Excellents résultats à des tests de référence tels que MATH et AIME, ce qui le rend particulièrement performant en matière de raisonnement symbolique et de résolution de problèmes.

- Autocertification et réflexion - Génère des chaînes de raisonnement internes et peut autocontrôler les réponses, ce qui améliore la fiabilité des tâches complexes à plusieurs étapes.

- Open-source et licence MIT - La licence entièrement permissive permet l'inspection, la modification et l'utilisation commerciale sans restriction, contrairement à la plupart des LLM propriétaires.

- Évolutivité et options de déploiement - Prise en charge de la quantification et des variantes distillées, permettant l'utilisation sur du matériel plus petit avec une perte de performance minimale.

- Prise en charge multilingue - Formation en plusieurs langues (dont l'anglais et le chinois), ce qui permet une application plus large pour les développeurs du monde entier.

Avantages et inconvénients :

🟢 Pour :

- Génère des solutions complètes et fonctionnelles avec une grande fiabilité.

- Prend en charge de grandes bases de code avec un contexte étendu de 128k.

- Le mode "Think" améliore le raisonnement pour les tâches de programmation complexes.

- Modèle à poids ouvert avec des coûts d'exploitation réduits.

🔴 Cons:

- Précision limitée dans le suivi d'instructions de codage détaillées.

- Sorties verbeuses, en particulier en mode raisonnement.

- Traîne les modèles leaders en matière de qualité de code.

- Risques potentiels de sécurité et d'alignement dans le code généré.

Tarification

La V3.1 est un modèle rentable et polyvalent, avec des jetons d'entrée au prix de 0,07 $ pour 1 million (cache hit) ou 0,56 $ pour 1 million (cache miss), et des jetons de sortie au prix de1,68 $ pour 1 million. Il est donc très intéressant pour les cas d'utilisation de gros volumes, en particulier lorsque la mise en cache est efficace.

R1, positionné comme un modèle de raisonnement haut de gamme, coûte environ 0,14 $ par million de jetons d'entrée et environ 2,19 $ par million de jetons de sortie.

5. Meilleur logiciel libre (grand contexte) : Meta Llama 4

Les modèles ouverts les plus récents de Meta, Llama 4 Scout et Maverick (sortis en avril 2025), augmentent considérablement la longueur du contexte, Scout (17B paramètres) supportant jusqu'à 10 millions de tokens et gérant l'entrée multimodale. Scout démontre des améliorations significatives en matière de codage, avec une plus grande précision sur des benchmarks tels que MBPP et une meilleure gestion des tâches de programmation longues et multi-fichiers par rapport à Llama 3. Les développeurs peuvent utiliser Scout pour gérer des tâches de codage complexes telles que les refactors multi-fichiers, le suivi des dépendances ou l'analyse du système de bout en bout sans que le modèle "oublie" le contexte antérieur. Comme il s'agit d'un logiciel libre et commercialement utilisable, les équipes peuvent l'adapter à leurs propres flux de travail et l'exécuter en toute sécurité sur du matériel local.

Principales capacités :

- Génération de code - Produit un code précis et fonctionnel pour un large éventail de tâches de programmation.

- Codage interactif - Prend en charge l'achèvement du code en temps réel, l'édition et l'assistance au débogage.

- Appel de fonctions - Génère des sorties structurées (par exemple, JSON) pour appeler des API ou s'intégrer à des outils externes.

- Gestion de code à grande échelle - Gestion de référentiels entiers ou de projets multi-fichiers sans perte de contexte, grâce à sa fenêtre de 10 millions de jetons.

- Suivi des instructions - S'adapte précisément aux invites spécifiques au codage pour des tâches telles que la correction de bogues, le remaniement ou la conception d'algorithmes.

- Déploiement efficace - Fonctionne efficacement sur du matériel local, ce qui rend l'assistance au codage à grande échelle plus accessible.

- Raisonnement sur le code - Comprend les dépendances et la sémantique au sein des bases de code, ce qui permet d'effectuer des analyses plus approfondies et de mieux comprendre le système.

Avantages et inconvénients :

🟢 Avantages :

- Inférence rapide, pratique pour une utilisation locale du codage.

- Scores de codage compétitifs parmi les modèles ouverts.

- Gère de très longues fenêtres de code/contexte.

- Poids ouvert et personnalisable pour un usage privé.

- Se situe derrière les meilleurs modèles (GPT-5, Claude) en ce qui concerne la précision du codage.

- Manque de cohérence ou bogue dans les tâches de codage les plus complexes.

- Le style de sortie peut sembler sec ou synthétique.

- Retour d'information limité sur l'adoption.

Prix

Le prix du Llama 4 est actuellement d'environ 0,15 $/M en entrée et 0,50 $/M en sortie pour Scout, et de 0,22-0,27 $/M en entrée et 0,85 $/M en sortie pour Maverick, variant légèrement selon le fournisseur.

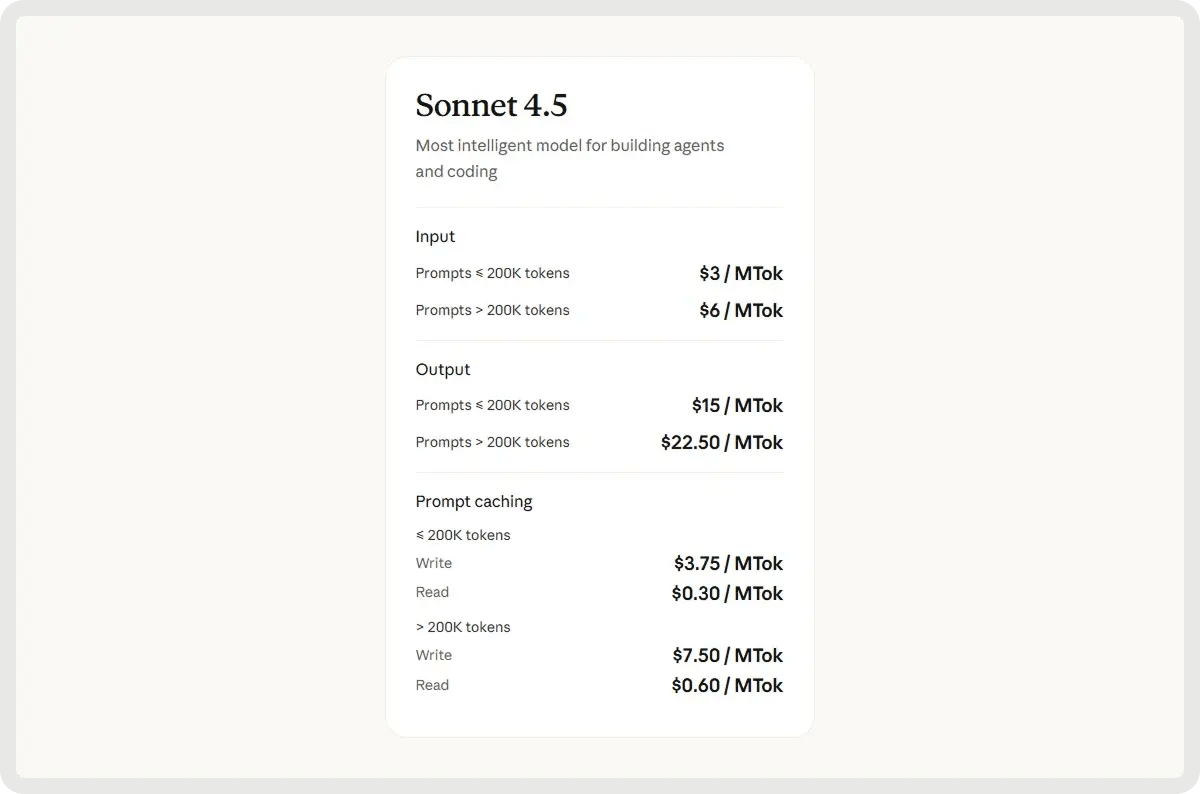

6. Meilleur pour le débogage collaboratif et les tâches à contexte long : Claude Sonnet 4.5

Claude Sonnet 4.5 est le modèle de raisonnement hybride le plus récent et le plus performant d'Anthropic, développant Sonnet 4 avec une intelligence plus fine, une génération de code plus rapide et une coordination agentique améliorée. Il dispose d'une fenêtre contextuelle de 200K-tokens, d'une plus grande précision dans l'utilisation des outils, et d'une connaissance affinée des domaines du codage, de la finance et de la cybersécurité. Optimisé pour un raisonnement étendu et une collaboration à grande échelle, il excelle dans la gestion de projets de codage complexes, d'agents autonomes et de tâches analytiques de longue haleine.

Principales capacités :

- Génération de code de bout en bout - Gère l'ensemble du cycle de développement logiciel, de la planification à la mise en œuvre, en passant par le débogage, le remaniement et la maintenance.

- Raisonnement avancé - Effectue des analyses logiques en plusieurs étapes et suit des instructions complexes pour résoudre des problèmes de programmation sophistiqués.

- Correction automatisée des erreurs - Détecte, explique et corrige les problèmes de code en temps réel afin d'améliorer la fiabilité et de réduire les efforts de débogage.

- Fenêtre contextuelle étendue - Prend en charge jusqu'à 64 000 jetons pour comprendre les bases de code volumineuses, les documents de conception et les dépendances à l'échelle d'un projet sans perdre le contexte.

- Intégration autonome des outils - Sélectionne et exploite les outils de développement appropriés, tels que les compilateurs, les interprètes et les systèmes de contrôle des versions, pour rationaliser les flux de travail.

- Cybersécurité proactive - Identifie, atténue et corrige les vulnérabilités de manière autonome afin de maintenir des bases de code sûres et résistantes.

- Fonctionnement persistant de l'agent - Exécution de tâches de codage de longue durée et gestion de flux de travail en plusieurs étapes, en continu, au fil des sessions.

Avantages et inconvénients :

🟢 Avantages :

- Forte précision de raisonnement et de codage d'une tâche à l'autre.

- Excellente rétention du contexte et connaissance des fichiers multiples.

- Utilisation efficace des outils et résolution structurée des problèmes.

- Capable de sessions de codage plus longues et plus autonomes.

- Réponses plus lentes lors d'un raisonnement approfondi ou d'une planification.

- Dérive occasionnelle des instructions et erreurs factuelles.

- Fenêtre contextuelle encore limitée pour les très grands projets.

- Difficultés avec les environnements interactifs

Prix

Le prix de Sonnet 4.5 commence à 3$ par million de jetons d'entrée et à 15$ par million de jetons de sortie.

Des modèles aux flux de travail : Rendre les LLMs pratiques avec Zencoder

Maintenant que vous connaissez les 6 meilleurs LLM pour le codage, la prochaine question est de savoir comment les mettre en pratique dans votre développement quotidien. Même les modèles les plus avancés nécessitent un système approprié pour s'intégrer à vos outils, automatiser les flux de travail et fournir des résultats cohérents dans le cadre de projets de grande envergure.

C'est là que Zencoder intervient ! Il vous permet de brancher votre (ou vos) modèle(s) favori(s) sur un agent de codage de niveau production qui rationalise les flux de travail, gère l'intégration et garantit la fiabilité à grande échelle.

Qu'est-ce que Zencoder ?

Zencoder est un agent de codage alimenté par l'IA qui améliore le cycle de vie du développement logiciel (SDLC) en améliorant la productivité, la précision et la créativité grâce à des solutions d'intelligence artificielle avancées. Grâce à sa technologie Repo Grokking™, Zencoder analyse en profondeur l'ensemble de votre base de code, découvrant les modèles structurels, la logique architecturale et les implémentations personnalisées.

De plus, avec la compatibilité universelle des outils, vous pouvez apporter votre propre CLI, y compris Claude Code, OpenAI Codex, ou GoogleGemini, directement dans votre IDE avec un contexte complet. Il offre également une intelligence multi-repo, permettant à Zencoder de comprendre les bases de code à l'échelle de l'entreprise, les connexions de service et la propagation des dépendances.

Voici quelques-unes des principales caractéristiques de Zencoder :

1️⃣ Intégrations - Zencoder s'intègre de manière transparente à plus de 20 environnements de développement, simplifiant ainsi l'ensemble de votre cycle de développement. Zencoder est le seul agent de codage d'IA à offrir un tel niveau d'intégration.

4️⃣ Assistant de codage AI tout-en-un - Accélérez votre flux de travail de développement avec une solution AI intégrée qui fournit une complétion de code intelligente, une génération de code automatique et des révisions de code en temps réel.

- Complétion de code - Des suggestions de code intelligentes vous permettent de continuer sur votre lancée grâce à des compléments précis et adaptés au contexte qui réduisent les erreurs et améliorent la productivité.

- Génération de code - Produit un code propre, cohérent et prêt pour la production, adapté aux besoins de votre projet et parfaitement aligné sur vos normes de codage.

- Agent de révision du code - La révision continue du code garantit que chaque ligne respecte les meilleures pratiques, détecte les bogues potentiels et améliore la sécurité grâce à un retour d'information précis et exploitable.

- Chat Assistant - Obtenez des réponses instantanées et fiables, ainsi qu'une assistance au codage personnalisée. Restez productif grâce à des recommandations intelligentes qui assurent la fluidité et l'efficacité de votre flux de travail.

3️⃣ Triple sécurité - Zencoder est le seul agent de codage IA certifié SOC 2 Type II, ISO 27001 et ISO 42001.

5️⃣ Zentester - Zentester utilise l'IA pour automatiser les tests à tous les niveaux, afin que votre équipe puisse détecter les bogues rapidement et livrer un code de haute qualité plus vite. Décrivez simplement ce que vous voulez tester en anglais, et Zentester s'occupe du reste, en s'adaptant à l'évolution de votre code.

Regardez Zentester en action :

Voici ce qu'il fait :

- Nos agents intelligents comprennent votre application et interagissent naturellement entre les couches d'interface utilisateur, d'API et de base de données.

- Au fur et à mesure que votre code évolue, Zentester adapte automatiquement vos tests, éliminant ainsi le besoin d'une réécriture constante.

- Des fonctions unitaires aux flux d'utilisateurs de bout en bout, chaque couche de votre application est testée en profondeur à grande échelle.

- L'IA de Zentester identifie les chemins de code à risque, découvre les cas limites cachés et crée des tests basés sur la façon dont les utilisateurs réels interagissent avec votre application.

6️⃣ Zen Agents - Les Zen Agents sont des coéquipiers IA entièrement personnalisables qui comprennent votre code, s'intègrent de manière transparente à vos outils existants et peuvent être déployés en quelques secondes.

Avec Zen Agents, vous pouvez :

- Construire plus intelligemment - Créer des agents spécialisés pour des tâches telles que l'examen des demandes d'extraction, les tests ou le remaniement, adaptés à votre architecture et à vos frameworks.

- Intégrer rapidement - Se connecter à des outils comme Jira, GitHub, et Stripe en quelques minutes en utilisant notre interface MCP sans code, afin que vos agents s'exécutent directement dans vos flux de travail existants.

- Déploiement instantané - Déployez des agents dans toute votre organisation en un seul clic, avec des mises à jour automatiques et un accès partagé pour maintenir l'alignement des équipes et l'évolutivité de l'expertise.

- Explorezla place de marché - Parcourez une bibliothèque croissante d'agents open-source préconstruits, prêts à être intégrés à votre flux de travail, ou contribuez vous-même pour aider la communauté à progresser plus rapidement.

Démarrez avec Zencoder gratuitement et transformez n'importe quel LLM en un agent de codage prêt pour la production !